博主辛苦了,我要打赏银两给博主,犒劳犒劳站长。

【摘要】Hadoop实现了一个分布式文件系统(Hadoop Distributed File System),简称HDFS。Hadoop的框架最核心的设计就是:HDFS和MapReduce。HDFS为海量的数据提供了存储,则MapReduce为海量的数据提供了计算。

单词计数是最简单也是最能体现MapReduce思想的程序之一,可以称为MapReduce版"Hello World",该程序的完整代码可以在Hadoop安装包的"src/examples"目录下找到。单词计数主要完成功能是:统计一系列文本文件中每个单词出现的次数,如下图所示:

执行wordcount程序的基本步骤如下:

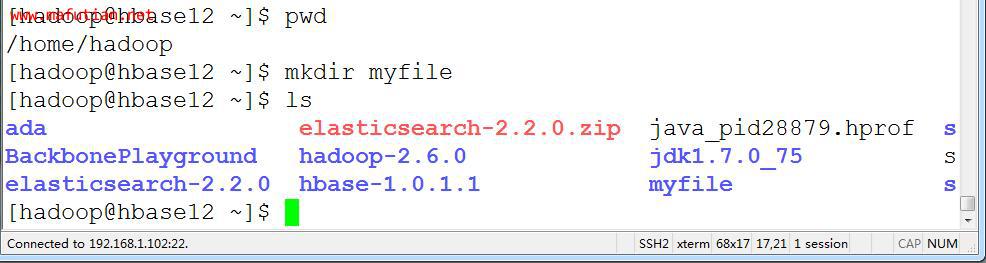

1)创建本地的示例文件

在"/home/hadoop"目录下创建文件夹"myfile"

[hadoop@hbase12 ~]$ pwd

[hadoop@hbase12 ~]$ mkdir myfile

[hadoop@hbase12 ~]$ ls

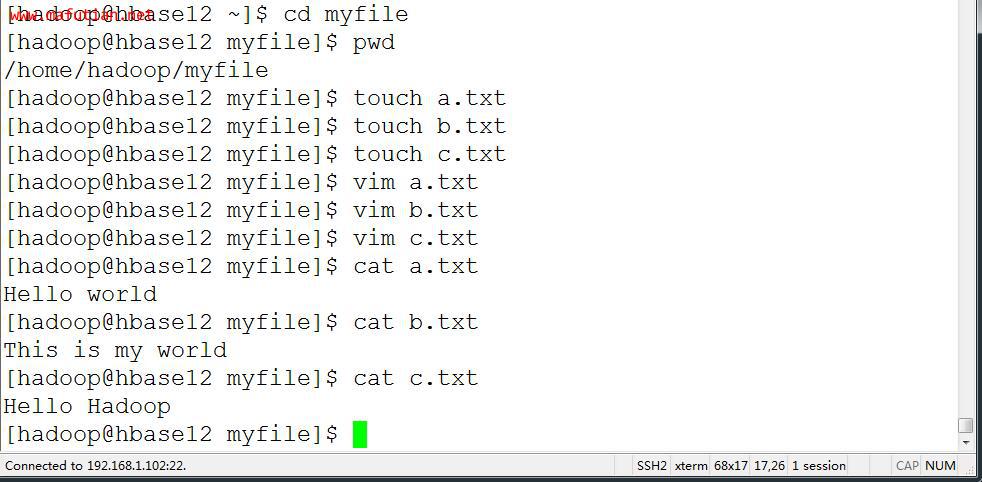

接着在"myfile"目录中创建若干个文本文件(名称可以任意),例如:a.txt,b.txt,c.txt,并且分别在文件中写入几个单词,如"Hello world","this is my world","Hello Hadoop"等等,如下图所示:

[hadoop@hbase12 ~]$ cd myfile

[hadoop@hbase12 myfile]$ pwd

[hadoop@hbase12 myfile]$ touch a.txt

[hadoop@hbase12 myfile]$ touch b.txt

[hadoop@hbase12 myfile]$ touch c.txt

[hadoop@hbase12 myfile]$ vim a.txt

[hadoop@hbase12 myfile]$ vim b.txt

[hadoop@hbase12 myfile]$ vim c.txt

[hadoop@hbase12 myfile]$ cat a.txt

[hadoop@hbase12 myfile]$ cat b.txt

[hadoop@hbase12 myfile]$ cat c.txt

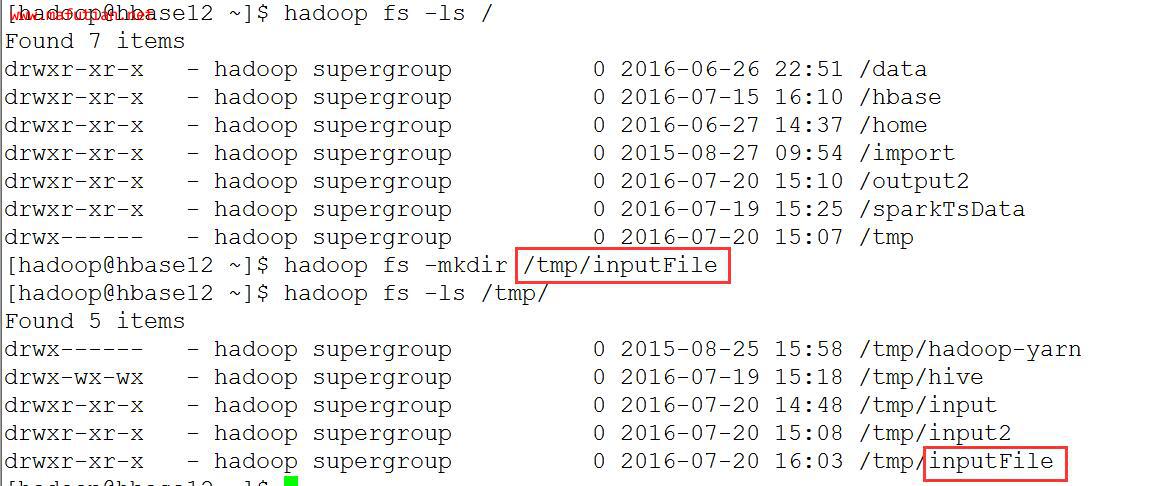

2)在HDFS(Hadoop分布式文件系统)中创建输入目录(文件夹)

[hadoop@hbase12 ~]$ hadoop fs -ls /

[hadoop@hbase12 ~]$ hadoop fs -mkdir /tmp/inputFile

[hadoop@hbase12 ~]$ hadoop fs -ls /tmp/

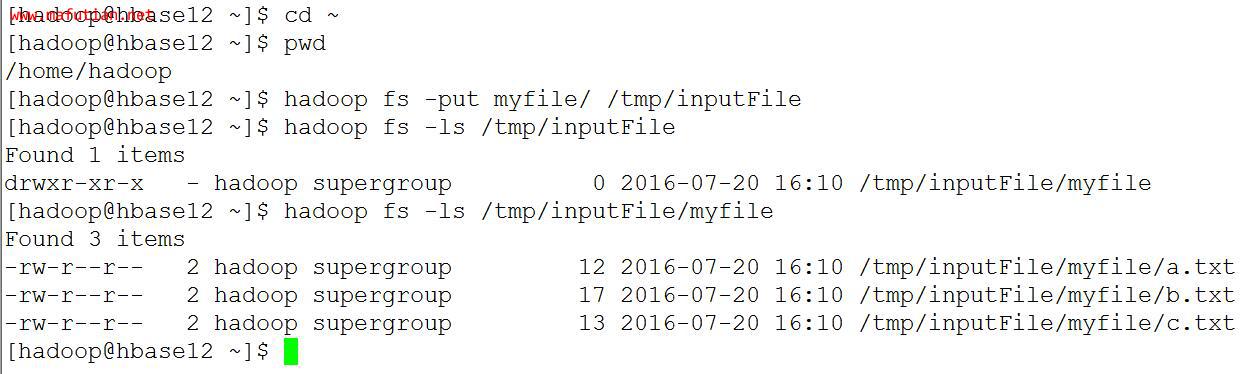

3)将本地的myfile文件上传到HDFS集群的inputFile目录下面

[hadoop@hbase12 ~]$ cd ~

[hadoop@hbase12 ~]$ pwd

[hadoop@hbase12 ~]$ hadoop fs -put myfile/ /tmp/inputFile

[hadoop@hbase12 ~]$ hadoop fs -ls /tmp/inputFile

[hadoop@hbase12 ~]$ hadoop fs -ls /tmp/inputFile/myfile

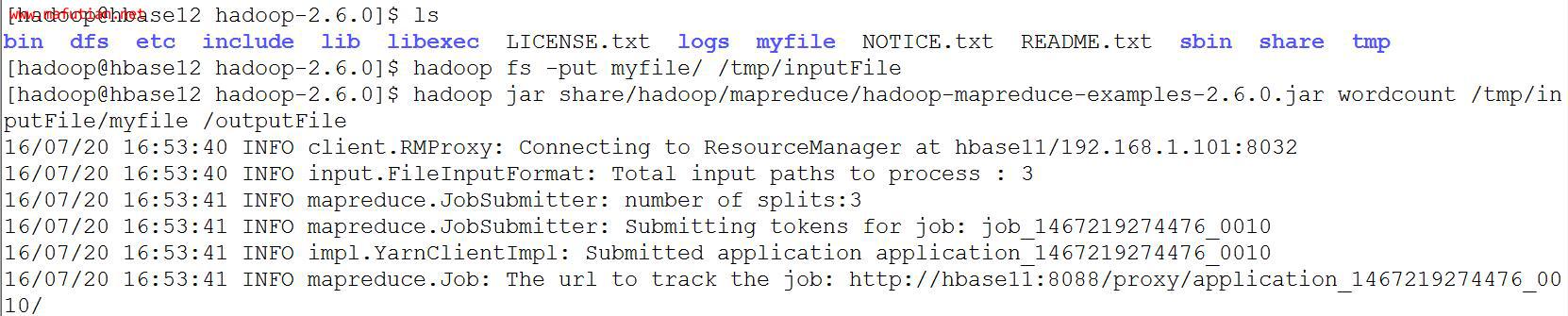

4)在集群上运行wordcount程序

备注:以/tmp/inputFile作为输入目录,/outputFile作为输出目录:

[hadoop@hbase12 ~]$ cd hadoop-2.6.0/

[hadoop@hbase12 hadoop-2.6.0]$ hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.6.0.jar wordcount /tmp/inputFile/myfile /outputFile

5)MapReduce执行过程显示信息

6)查看HDFS上output目录内容

[hadoop@hbase12 hadoop-2.6.0]$ hadoop fs -ls /

[hadoop@hbase12 hadoop-2.6.0]$ hadoop fs -ls /outputFile

[hadoop@hbase12 hadoop-2.6.0]$ hadoop fs -cat /outputFile/part-r-00000

版权归 马富天个人博客 所有

本文链接地址:http://www.mafutian.com/165.html

转载请务必注明出处,小生将不胜感激,谢谢! 喜欢本文或觉得本文对您有帮助,请分享给您的朋友 ^_^

顶1

踩0

第 1 楼 雪山贷 2016-07-20 17:34:07 江苏苏州

| 评论审核未开启 |

|

||